Stability AI釋出了一個新的開源AI語言模型系列,名為StableLM。Stability公司希望重複其在2022年推出的Stable Diffusion開源影象合成模型的催化作用。經過完善,StableLM可以用來構建開源ChatGPT平替。

據Stability公司稱,StableLM目前在GitHub上以alpha形式提供30億和70億引數的模型,隨後將有150億和650億引數的模型。該公司在知識共享BY-SA-4.0許可下發布了這些模型,該許可要求改編必須歸功於原創作者並共享相同的許可。

Stability AI Ltd.是一家位於倫敦的公司,它將自己定位為OpenAI的一個開源對手,儘管OpenAI有一個 “開放 “的名字,但它很少釋出開源模型,並將其神經網路權重–定義人工智慧模型核心功能的大量數字–保留為專有。

“語言模型將構成我們數字經濟的支柱,我們希望每個人都能在其設計中擁有發言權,”Stability公司在一篇介紹博文中寫道。”像StableLM這樣的模型表明我們對人工智慧技術的承諾是透明的、可訪問的和支援性的。”

與GPT–為最強大的ChatGPT版本提供動力的大型語言模型(LLM)一樣,StableLM通過預測一個序列中的下一個標記(單詞片段)來生成文字。該序列以人類以 “提示 “形式提供的資訊開始。因此,StableLM可以編寫類似人類的文字,並編寫程式。

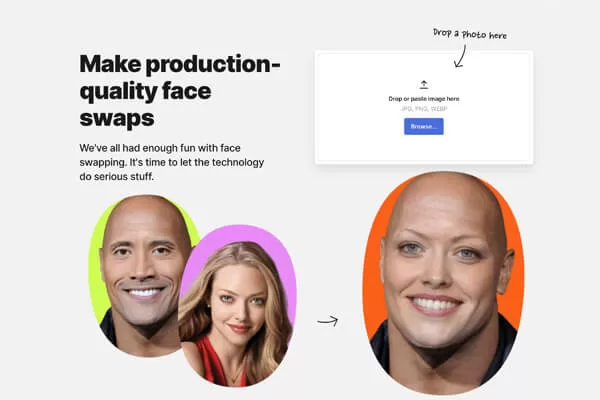

Stability AI提供的7B引數StableLM語言模型的微調版本的對話截圖示例:

像其他最近的 “小 “語言模型,如Meta的LLaMA、斯坦福的Alpaca、Cerebras-GPT和Dolly 2.0,StableLM聲稱要達到與OpenAI的基準GPT-3模型類似的效能,而使用的引數卻少得多–StableLM是70億,而GPT-3是1750億。

引數是語言模型用來從訓練資料中學習的變數。引數越少,語言模型就越小,效率就越高,這可以使它更容易在智慧手機和膝上型電腦等本地裝置上執行。然而,用較少的引數實現高效能需要精心設計,這是人工智慧領域的一個重大挑戰。

“我們的StableLM模型可以生成文字和程式碼,並將為一系列的下游應用提供動力,”Stability說。”它們展示了小而有效的模型如何通過適當的訓練提供高效能”。

根據Stability AI的說法,StableLM已經在 “一個新的實驗資料集 “上進行了訓練,該資料集基於一個名為The Pile的開源資料集,但比它大三倍。Stability公司聲稱,這個資料集的 “豐富性”–它承諾稍後公佈其細節–說明了該模型在對話和編碼任務的較小引數規模下 “令人驚訝的高績效”。

在我們對基於Alpaca方法為對話建立的StableLM的7B模型的微調版本的非正式實驗中,我們發現它似乎比Meta的原始7B引數LLaMA模型表現得更好(就你在提示下所期望的輸出而言),但沒有達到GPT-3的水平。更大引數版本的StableLM可能會被證明更加靈活和有能力。

去年8月,Stability公司資助並宣傳了Stable Diffusion的開源釋出,該模型由慕尼黑路德維希-馬克西米利安大學的CompVis小組的研究人員開發。

作為一個早期的開源latent diffusion模型,它可以從提示中生成影象,Stable Diffusion啟動了一個影象合成技術的快速發展時代。它也在藝術家和企業實體中引起了強烈的反響,其中一些人已經起訴了Stability AI。Stability公司向語言模型的進軍可能會激發類似的結果。

使用者可以測試70億個引數的StableLM基礎模型Hugging Face和Replicate上的微調模型。此外,Hugging Face承載了一個對話調整版的StableLM,其對話格式與ChatGPT相似。

Stability公司表示,它將 “在不久的將來” 釋出一份關於StableLM的完整技術報告。

評論留言